Google è il motore di ricerca più utilizzato al mondo. E il motivo è semplice: la sua capacità di analizzare in pochi secondi milioni di siti e restituire una classifica dei migliori risultati (la Search Engine Results Page o semplicemente detta “SERP”), in base alla query digitata.

Il suo algoritmo viene aggiornato costantemente per rispondere alla “sovrappopolazione” di contenuti online e assicurare all’utente risposte sempre più precise e utili.

In questo articolo, facciamo un salto nel tempo per ripercorrere insieme le tappe principali dell’evoluzione algoritmica di Google nell’ultimo decennio, così da darti una base per costruire delle strategie SEO efficaci ed evitare penalizzazioni.

Perché è fondamentale conoscere l’algoritmo di Google

Chi gestisce un sito o si occupa di SEO sa quanto sia importante comprendere il funzionamento dell’algoritmo di Google. È infatti il motore di ricerca a decidere, aggiornamento dopo aggiornamento, chi compare nelle prime posizioni della SERP e chi, invece, sprofonda nel dimenticatoio.

L’algoritmo si basa ancora sul PageRank, uno dei suoi pilastri originari, ma oggi tiene conto di oltre 200 Fattori di Ranking, tra elementi noti e altri gelosamente custoditi da Google. In particolare, possiamo parlare di due tipologie di fattori:

- Fattori On Page: legati alla struttura e ai contenuti del sito (come parole chiave, tag HTML, coerenza semantica)

- Fattori Off Page: riguardano la popolarità, i link in ingresso e il comportamento degli utenti.

Una strategia SEO efficace si costruisce proprio sull’equilibrio tra questi elementi, cercando di rispondere al meglio ai criteri dell’algoritmo.

Ma c’è un problema: gli aggiornamenti sono frequenti e, quando arrivano, possono modificare del tutto le regole del gioco. Parametri prima “positivi” possono perdere peso o diventare addirittura dannosi, portando a un crollo improvviso del traffico organico e, nei casi peggiori, a vere e proprie penalizzazioni SEO.

Per questo motivo, rimanere aggiornati sull’evoluzione dell’algoritmo e monitorare costantemente le performance del sito è l’unico modo per non farsi cogliere impreparati e mantenere la visibilità conquistata.

Updates: la cronistoria degli aggiornamenti di Google

Per offrire risposte sempre più precise e di qualità, Google aggiorna costantemente il suo algoritmo. L’obiettivo? Penalizzare le pratiche scorrette che portano in alto nella SERP siti poco affidabili e premiare i contenuti considerati di valore (soprattutto per gli utenti). Ogni anno vengono rilasciati oltre 500 aggiornamenti, anche se solo alcuni sono annunciati ufficialmente, mentre altri passano più inosservati.

I più temuti? I Core Update. Non hanno nomi ufficiali, ma possono avere un impatto enorme sul posizionamento, spesso senza indicazioni chiare sui parametri modificati. In sostanza, possiamo dire che, quando c’è un Core Update in vista, potreste sentire un SEO Specialist nel mondo tremare di terrore (e di curiosità, perché è pur sempre bello nerdare per qualcosa di nuovo). Sapendo il loro impatto, adesso, ripercorriamo gli aggiornamenti più significativi: quelli che, nel bene o nel male, hanno segnato un punto di svolta.

Google Panda – 2011

Introdotto nel 2011 (e aggiornato fino al 2016), Google Panda è stato uno degli update più significativi nella storia della SEO. Il suo obiettivo era quello di premiare i contenuti di qualità e penalizzare i siti poveri di spessore, duplicati o appartenenti a content farm. Da allora, copywriter e marketer hanno dovuto rivedere il modo di scrivere online: per essere visibili infatti serve offrire contenuti utili, pertinenti e ben strutturati. Ancora oggi, Panda resta un punto fermo nel sistema di ranking di Google.

Google Penguin – 2012

Dopo Panda, nel 2012 arriva Penguin Google, l’update pensato per contrastare i link artificiali e penalizzare chi abusa di pratiche scorrette nella link building. L’obiettivo? Premiare link naturali e pertinenti, penalizzando quelli spam o da fonti di bassa qualità. Con Penguin 4 (dal 2016), l’algoritmo lavora in tempo reale, colpendo subito le violazioni. Questo ha reso essenziale per chi fa SEO puntare su link autorevoli e coerenti, riducendo sensibilmente la presenza di progetti editoriali senza qualità in cima alle SERP.

Google Hummingbird – 2013

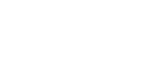

Con Hummingbird, Google compie un salto nella comprensione semantica delle query. Lanciato nel 2013, questo aggiornamento permette al motore di ricerca di interpretare il significato reale delle parole e delle frasi, oltre che abbinarle letteralmente. È grazie a Hummingbird se oggi Google riesce a rispondere con precisione a ricerche conversazionali come “dove mangiare sushi a Milano”. Lavora sul contesto, valorizzando le keyword a coda lunga e l’uso di dati strutturati, che aiutano l’algoritmo a capire davvero di cosa parla una pagina.

Un esempio pratico su come Google riesca a capire l’intera frase di ricerca dell’utente “Come faccio a creare annunci su Google?”- espressa in maniera colloquiale- piuttosto che analizzando singolarmente le parole della frase.

Google Pigeon – 2014

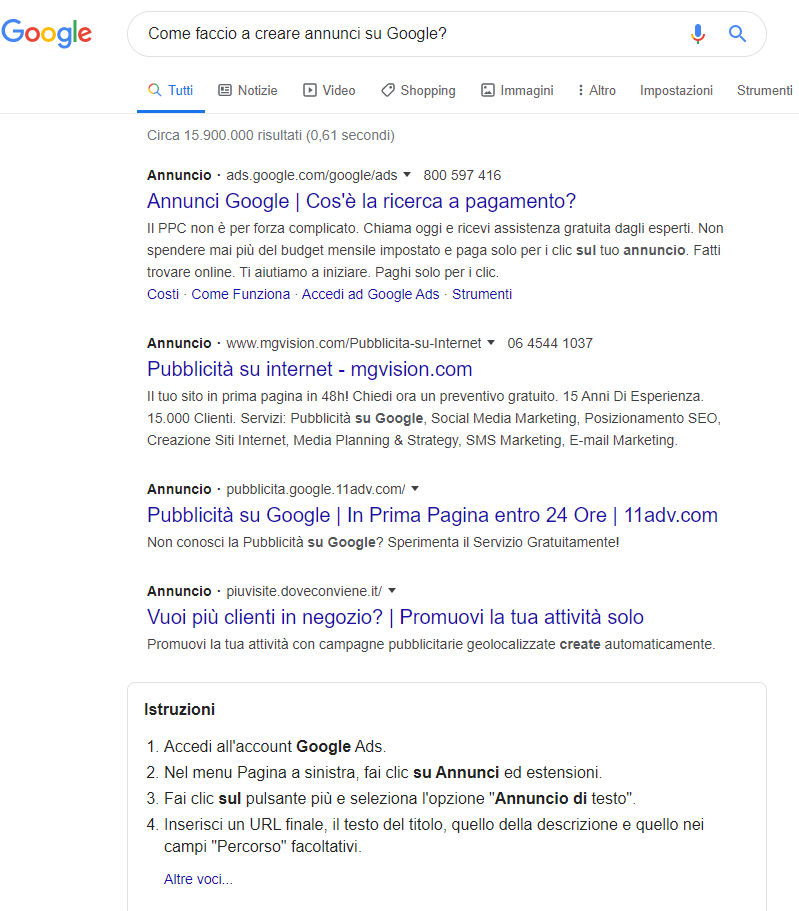

Google Pigeon viene lanciato nel 2014 con lo scopo di rendere i risultati di ricerca più precisi in base alle esigenze dell’utente. Questo algoritmo manipola i risultati della SERP in base alla geolocalizzazione dell’utente, integrandosi con le funzioni di altri algoritmi. È molto utile quando si sta ricercando un ristorante, un’agenzia o qualsiasi altro servizio/luogo nelle vicinanze.

Google RankBrain e Mobilgeddon – 2015

Nel 2015 Google introduce due aggiornamenti chiave. Con RankBrain, il motore di ricerca sfrutta il machine learning per interpretare meglio le intenzioni dell’utente, combinando keyword, cronologia e posizione geografica per offrire risultati sempre più personalizzati. In parallelo, arriva Mobilgeddon, l’update che penalizza i siti non ottimizzati per mobile. Da qui nasce l’imperativo: progettare prima per smartphone e poi per desktop. Un sito “mobile friendly” non è più un’opzione, ma una necessità, sia per la SEO che per il successo delle campagne Google Ads.

Google Possum – 2016

Lanciato nel 2016, Google Possum ha rivoluzionato la Local SEO, migliorando il posizionamento delle attività vicine alla posizione dell’utente, sebbene appena fuori dai confini cittadini. Ha reso i risultati più personalizzati e ha introdotto un nuovo filtro basato sull’indirizzo: le attività con schede Google My Business diverse ma situate nello stesso edificio non compaiono tutte, salvo che l’utente non rimuova manualmente il filtro. Oltre a ciò, anche lievi variazioni nelle keyword (“Bologna osteria” vs “osteria Bologna”) possono generare risultati diversi.

Google Fred – 2017

Nel 2017, Google Fred colpisce duramente i siti con contenuti fuorvianti, copiati o creati solo per generare traffico e monetizzare. L’update punta il dito contro le fake news, la sovraottimizzazione e l’eccessiva presenza di pubblicità. Se da un lato ne risultano penalizzati molti siti, anche noti, altri brand percepiti come più affidabili guadagnano visibilità. L’obiettivo è chiaro: valorizzare contenuti originali, autorevoli e realmente utili all’utente.

Mobile – First Update – 2017

Nel 2017 Google inverte le regole del gioco con il Mobile-First Indexing: l’indicizzazione parte dalla versione mobile del sito, non più da quella desktop. Con sempre più utenti attivi da smartphone, diventa indispensabile progettare prima per il mobile e poi adattare al desktop. Da marzo 2017, un sito non ottimizzato per mobile fatica a posizionarsi anche su desktop. Google fornisce linee guida chiare: accesso totale ai contenuti da mobile, parità tra versioni (contenuti, metadati, dati strutturati) e media ottimizzati per dispositivi mobili. L’obiettivo? Massima User Experience e capacità del sito di trattenere l’utente al suo interno il più a lungo possibile.

Medic Update – 2018

Ad agosto 2018, Google rilascia un Core Update che stravolge le SERP, colpendo specialmente i siti del settore medico, chiamato proprio per questo Medic Update. L’obiettivo è migliorare la qualità dei risultati, distinguendo tra intenti informativi e commerciali, e promuovendo contenuti autorevoli. Google inizia così a premiare strutture orientate all’inbound marketing, dove l’utente passa da un contenuto informativo alla scoperta e all’acquisto. L’update ha penalizzato anche siti senza apparenti colpe, ma la situazione si è in parte riequilibrata con gli aggiornamenti successivi.

Google BERT e Core Update – 2019

BERT, lanciato a novembre 2019, è uno degli aggiornamenti più rivoluzionari di Google. Pensato per comprendere meglio le query complesse, analizza il contesto delle frasi (preposizioni incluse) e non più ogni parola singolarmente, migliorando notevolmente la qualità dei risultati — soprattutto per ricerche conversazionali e vocali. Per la SEO, questo significa meno spazio per forzature keyword-driven e più attenzione alla scrittura naturale e di qualità.

Nel 2019 Google ha anche rilasciato tre Core Update:

- March 2019 Core Update: nessun settore specifico colpito. L’unico consiglio di Google? Continuare a creare contenuti di qualità.

- June 2019 Core Update: annunciato in anticipo, ha colpito siti di news, mentre quelli in ambito medico hanno recuperato terreno rispetto al Medic Update.

- September 2019 Core Update: ha influenzato la valutazione qualitativa dei domini, penalizzando soprattutto siti di salute, finanza e viaggi.

Il trend è chiaro: Google punta a premiare contenuti realmente utili e ben strutturati. E la “cura” resta sempre la stessa: qualità, autorevolezza e attenzione all’intento di ricerca dell’utente.

Core Updates – 2020

Il 2020 è stato un anno intenso per la SEO, con tre importanti Core Update rilasciati da Google: gennaio, maggio e dicembre. Ognuno ha avuto impatti significativi sulla SERP e ha ribadito un messaggio chiaro: la qualità dei contenuti è più cruciale che mai.

- January 2020 Core Update

Lanciato il 13 gennaio, ha introdotto modifiche nell’analisi semantica delle query, generando cali di traffico per molti siti. Google ha incoraggiato i webmaster a valutare la qualità dei propri contenuti attraverso una serie di domande, suddivise in quattro aree: contenuto originale e approfondito, autorevolezza e competenza, cura nella presentazione e valore rispetto ai competitor. Il rilascio ha portato anche a un restyling della SERP, con nuove etichette per gli annunci e modifiche alla visualizzazione degli URL, soprattutto da mobile.

- May 2020 Core Update

Annunciato il 4 maggio in piena pandemia, è stato definito da alcuni come “Corona Update”, anche se Google non ha mai confermato un legame diretto con il contesto globale. In un periodo in cui le ricerche si erano concentrate su pochi temi (es. COVID-19, smart working, igiene), l’update ha spinto ancora di più verso la centralità dell’interazione-utente. Google ha ribadito l’importanza di contenuti utili, affidabili, ben realizzati e competitivi rispetto agli altri risultati in SERP.

- December 2020 Core Update

Chiude l’anno il December Core Update, con effetti evidenti a partire dal 4 dicembre. L’ambito di intervento non è stato chiarito nei dettagli, ma l’update ha colpito in particolare i settori immobiliare, viaggi e salute. Come per gli update precedenti, Google consiglia di verificare la qualità e la pertinenza dei contenuti, valutando anche eventuali cambiamenti nel search intent o negli interessi degli utenti.

Google Mobile Only e Google Page Experience – 2021

Il 2021 segna una svolta epocale per la SEO con due aggiornamenti chiave: Google Mobile Only e Google Page Experience. Da marzo, solo la versione mobile dei siti conta per l’indicizzazione: non essere ottimizzati per smartphone significa (ormai) sparire dalla SERP.

Con Page Experience, attivo da giugno, Google introduce metriche precise per valutare l’esperienza utente: Core Web Vitals, sicurezza, assenza di ADV invasivo e mobile usability. I siti che non rispettano i criteri (tra cui HTTPS e navigazione sicura) rischiano penalizzazioni, esclusione da Rich Snippet o Knowledge Graph, e un alert su Google Search Console. Inoltre, non serve più usare AMP per comparire nei Top Stories.

Product Reviews Update – 2021

Nel 2021 Google alza l’asticella per le recensioni online, premiando quelle approfondite, originali e utili. L’aggiornamento, inizialmente rivolto ai contenuti in inglese, incoraggia schede prodotto che vadano oltre la descrizione base e offrano analisi da esperti, confronti, pro e contro, foto reali e valutazioni dettagliate. Così come nell’aggiornamento di Gennaio 2020, Google suggerisce di rispondere a domande chiave che un utente si farebbe prima dell’acquisto.

MUM Update – 2021

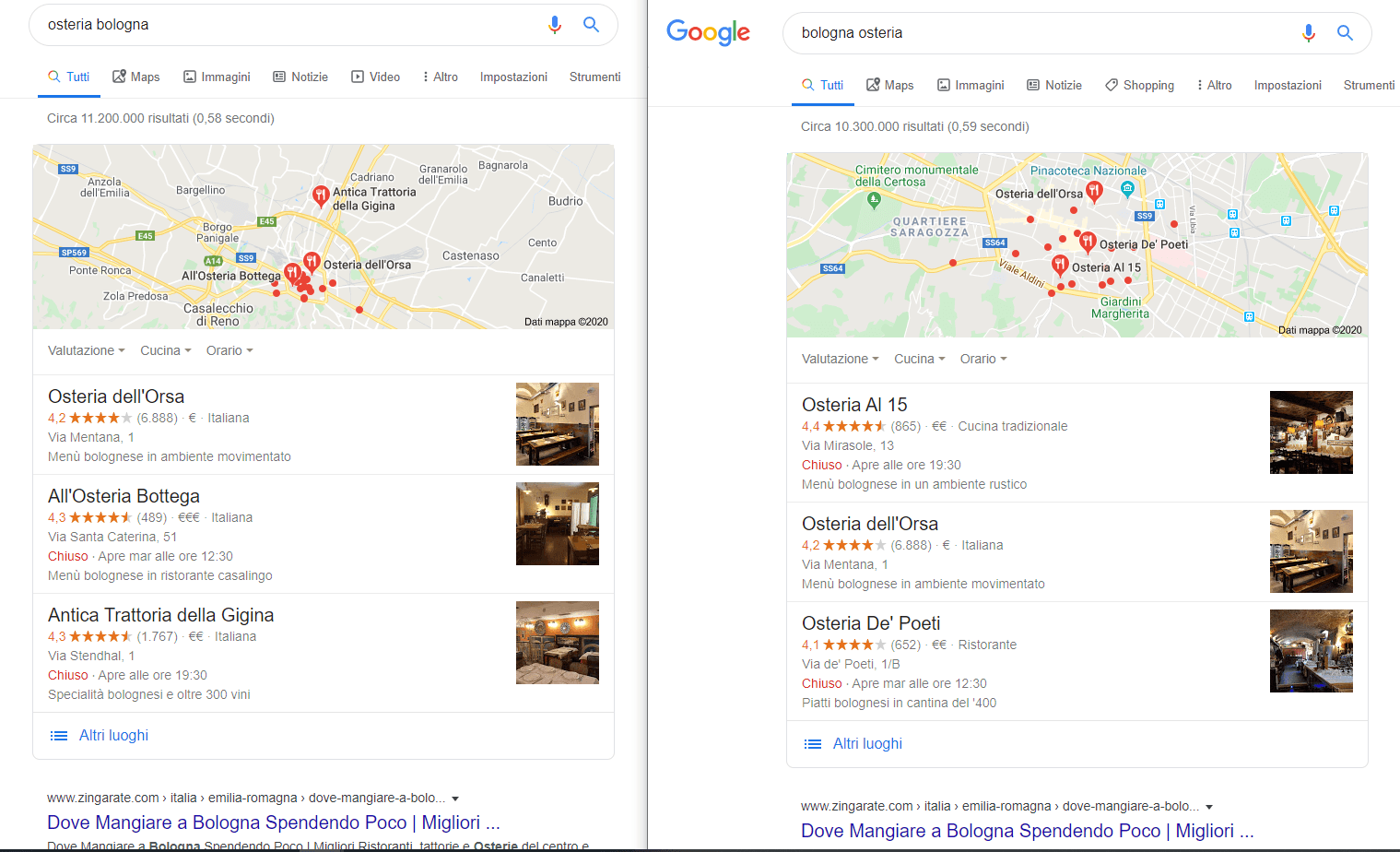

Lanciato a maggio 2021, MUM (Multitask Unified Model) rappresenta un’evoluzione epocale nella ricerca Google, superando Hummingbird, RankBrain e BERT. È un modello unificato capace di gestire indicizzazione, recupero informazioni e ranking in modo integrato.

A differenza dei modelli precedenti, MUM è multilingue e multimodale: analizza testo, immagini, video e audio per rispondere a query complesse con maggiore profondità semantica e contestuale. È mille volte più potente di BERT e punta a:

- Perfezionare l’esperienza di ricerca globale, in tutte le lingue.

- Arricchire il Knowledge Graph con dati testuali e multimediali.

- Offrire risposte sempre più precise, intuitive e complete.

Con MUM, Google integra contenuti multimodali per offrire risultati più intelligenti e rilevanti su scala mondiale.

Spam e Link Update – 2021

Tra giugno e luglio 2021, Google ha rilasciato due aggiornamenti cruciali:

- Spam Update: potenzia la capacità di Google nel rilevare contenuti spam, penalizzando pratiche di black-hat SEO e migliorando la qualità dei risultati in SERP.

- Link Update: mira a neutralizzare i link non naturali o manipolativi, valorizzando profili di backlink organici e autentici.

A supporto, sono stati introdotti nuovi attributi per classificare i link:

- rel=”sponsored” per link a pagamento o sponsorizzati;

- rel=”ugc” per link generati dagli utenti (commenti, forum).

In questo modo Google premia sempre di più contenuti autentici e strategie SEO etiche.

November 2021 Core Update

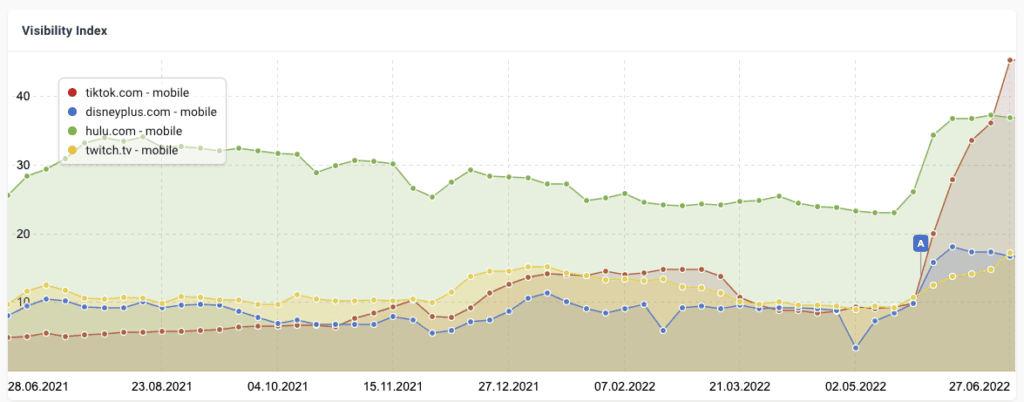

Il Core Update di novembre 2021 ha introdotto una forte volatilità nelle SERP, con impatti più marcati su mobile (+23%) rispetto al desktop (+12%). Il settore salute è stato il più colpito, registrando una variazione del 41% superiore rispetto all’update estivo.

Quasi il 7% delle pagine che prima erano oltre la seconda pagina sono salite nella top 10. Tra i settori più impattati:

- Viaggi: crescita per Expedia, TripAdvisor e Booking, stabilità per Airbnb.

- Magazine femminili: in ripresa dopo precedenti penalizzazioni.

- Vincitori: Collins Dictionary, Esquire, Cambridge.org.

- Perdenti: Euronics, National Geographic Italia.

Possiamo dire che questo Core Update ha riscritto gli equilibri in molte SERP verticali.

Page Experience (Desktop) – 2022

Nel febbraio 2022, Google estende l’aggiornamento Page Experience anche alla versione desktop dei siti. I fattori valutati includono velocità di caricamento, HTTPS, assenza di interstitial invasivi e navigazione sicura, già noti per il mobile come Core Web Vitals. L’obiettivo è lo stesso: accrescere la qualità percepita dell’esperienza utente su ogni dispositivo.

Product Reviews Update – 2022

Nel marzo 2022, Google rilascia la terza versione del Product Reviews Update, rafforzando l’importanza di recensioni di alta qualità. Le pagine dedicate dovrebbero includere:

- Analisi dettagliata con pro e contro.

- Prestazioni e confronti tra versioni.

- Contenuti originali, come foto e video propri.

- Elementi distintivi del prodotto rispetto ai concorrenti.

- Link utili a più opzioni d’acquisto.

L’obiettivo è aiutare gli utenti a prendere decisioni più informate, premiando contenuti autentici e approfonditi.

May 2022 Core Update

Il May 2022 Broad Core Update ha mirato a premiare siti con contenuti di alta qualità e penalizzare quelli con scarsa affidabilità. I criteri si basano sui principi E-A-T (Expertise, Authoritativeness, Trustworthiness), valutando contenuti utili, autorevoli e ben strutturati, uniti a una buona esperienza utente.

Secondo i dati di Semrush Sensor, l’impatto è stato forte in settori come:

- Immobiliare (+5.3% volatilità)

- Animali domestici (+3.9%)

- Viaggi e pesca (+3.7%)

È emersa anche una maggiore valorizzazione dei contenuti video, sempre più apprezzati dagli utenti per la loro immediatezza e capacità di engagement.

Helpful Content Update – 2022

Lanciato ad agosto 2022 (in italiano da dicembre), l’aggiornamento Helpful Content Update (HCU) ha introdotto uno dei cambiamenti più rilevanti nella SEO recente. L’obiettivo è premiare contenuti scritti da persone per persone, che offrano valore reale, esperienza diretta e soddisfino le aspettative degli utenti.

Google penalizza contenuti generici, scritti solo per attrarre traffico, senza competenze reali o utilità concreta. Per aumentare il ranking, diventa strategico implementare il “pruning” dei contenuti: rimuovere o aggiornare testi obsoleti, brevi o poco performanti, aiutando così sia l’utente che il crawling di Google a concentrarsi solo sulle pagine di qualità.

Core Updates e altri aggiornamenti – 2023

Il 2023 è stato un anno ricco di novità per l’algoritmo di Google, con quattro Core Update e diversi aggiornamenti complementari che hanno profondamente influenzato l’ecosistema SEO.

Core Update: qualità e rilevanza al centro

L’ultimo Google Core Update dell’anno, rilasciato il 2 novembre 2023, ha rappresentato un cambiamento significativo, impattando ricerche in tutte le lingue e aree geografiche. Come per ogni Core Update, l’obiettivo è perfezionare la qualità dei risultati in SERP, premiando i contenuti più rilevanti e pertinenti. Questi aggiornamenti generano sempre variazioni di traffico, richiedendo un’attività costante di monitoraggio per intercettare eventuali anomalie.

Prima di novembre, Google aveva già rilasciato altri tre Core Update:

- Marzo 2023 – Broad Core Update: ha colpito duramente siti in ambito news, finanza, salute e benessere, spesso legati ai contenuti YMYL (Your Money Your Life), con perdite di visibilità superiori al 50%.

- 22 agosto – August Core Update: ha generato forti oscillazioni, soprattutto nella TOP 10 della prima pagina.

- Ottobre 2023 – Core Update: volto a premiare l’informazione di qualità, ha causato ulteriori variazioni nei posizionamenti, ricalibrando i criteri di ranking.

Altri aggiornamenti del 2023

Oltre ai Core Update, Google ha introdotto una serie di aggiornamenti specifici mirati a ottimizzare l’esperienza degli utenti e l’affidabilità dei contenuti:

- Product Reviews Update (febbraio–marzo 2023): ha migliorato il modo in cui vengono valutate e posizionate le recensioni di prodotto, coinvolgendo diversi paesi e incentivando contenuti più dettagliati e autentici.

- Reviews Update (aprile 2023): ha aggiornato le linee guida relative alle recensioni su prodotti e servizi, con un impatto diretto sulle schede prodotto degli e-commerce.

- Helpful Content Update (settembre 2023): ha modificato alcune regole fondamentali sul ranking, intervenendo su temi come i contenuti generati da IA, i contenuti di terze parti e ha introdotto nuove linee guida per chi subisce cali di traffico dopo questi update.

- Spam Update (ottobre 2023): ha potenziato i sistemi di rilevamento automatizzato dello spam nei risultati di ricerca, riducendo la visibilità di contenuti generati automaticamente e di bassa qualità.

Core Updates – 2024

Il 2024 è stato un anno intenso sul fronte SEO: Google ha rilasciato aggiornamenti importanti che hanno riscritto — ancora una volta — le regole del gioco. Core Updates e Spam Updates hanno agito su più livelli, premiando i contenuti utili, penalizzando chi cerca scorciatoie. Il risultato? La qualità non è più un’opzione, è il requisito minimo per essere visibili.

Core Updates

Come ormai abbiamo ribadito più volte nell’articolo, i Core Updates sono aggiornamenti strutturali dell’algoritmo che incidono sulla valutazione complessiva dei contenuti e sul ranking nelle SERP. Nel 2024, Google ha spinto ancora di più verso la qualità, con un occhio attento a tre aree chiave:

- Contenuti originali e utili: testi che rispondono davvero alle intenzioni di ricerca, ben scritti, approfonditi, pensati per le persone.

- E-E-A-T rafforzato (Experience, Expertise, Authoritativeness, Trustworthiness): l’algoritmo punta a valorizzare contenuti scritti da chi ha reale competenza e autorevolezza nel proprio ambito.

- User Experience: la navigabilità del sito, la velocità di caricamento, la struttura delle pagine e la chiarezza visiva diventano fattori sempre più rilevanti nella valutazione finale.

Il Core Update di marzo è stato quello più impattante. Google ha dichiarato di aver migliorato la capacità di identificare contenuti originali e ha intensificato il contrasto a quelli generati con l’intelligenza artificiale per scalare la SERP senza reale autorevolezza. L’obiettivo è uno solo: premiare chi crea per l’utente, non per l’algoritmo.

Spam Updates

Nel 2024 Google ha continuato a lavorare sottotraccia (ma con effetti visibili) per stanare i contenuti e le strategie di posizionamento ingannevoli. Tra le principali attività:

- Link spam: penalizzazione per chi utilizza tecniche manipolative di link building (acquisti massivi di backlink, schemi sospetti).

- Content spam: stretta sui contenuti generati automaticamente o duplicati da altre fonti, senza valore aggiunto.

- Spam dannoso: maggiore capacità di rilevare siti potenzialmente pericolosi (phishing, malware).

Questi aggiornamenti — spesso non annunciati — hanno reso la SERP un ambiente più pulito, riducendo la visibilità dei contenuti tossici.

Altri aggiornamenti da tenere d’occhio

Google non si è limitato ai core e agli anti-spam. Altri trend hanno segnato l’anno:

- Search Generative Experience (SGE): l’intelligenza artificiale generativa sta cambiando l’aspetto delle SERP e il modo in cui vengono presentate le informazioni. Meno clic, più risposte dirette.

- Esperienza utente e Core Web Vitals: Google continua a premiare i siti tecnicamente solidi dal punto di vista di velocità, stabilità visiva e interattività.

- Aggiornamenti settoriali (es. recensioni di prodotto): nei settori specifici, Google introduce update mirati per aumentare l’affidabilità delle informazioni (recensioni, confronti, test reali, contenuti multimediali originali).

Cosa insegna l’evoluzione dell’algoritmo Google?

In un panorama SEO in continua evoluzione, restare aggiornati sull’algoritmo di Google — oggi più che mai complesso e selettivo — non è solo consigliabile: è ormai indispensabile. Dalla qualità dei contenuti alla stabilità tecnica del sito, fino alla capacità di rispondere con precisione all’intento di ricerca, ogni elemento conta.

Insomma, la direzione è chiara. Serve un approccio data-driven, strategico e focalizzato sull’utente reale. Perché alla fine, Google premia chi lavora per le persone e non (solo) per i motori.